Theoretical Mass Balance A Single Strike Boiling Scheme

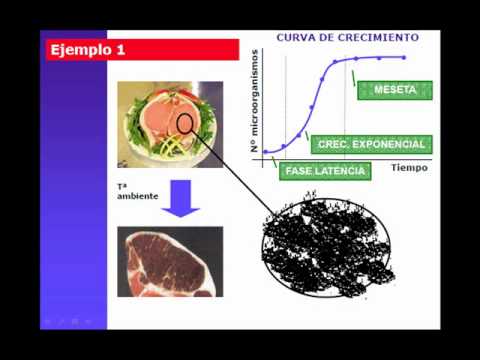

The refinery Mass and Energy Balance was developed using Sugars®. An extract from the diagram for that balance is shown in Figure It can be seen that the feedstock to the product boiling is made up of the two liquor streams:

- 124.79 t/h of fine liquor plus intermediate sugar melt, 340 ICUMSA, 99.39 purity

- 54.48 t/h of high purity product run-off, 1305 ICUMSA, 97.92 purity;

We should, at this point, perhaps turn to the core thesis of the 2005 paper: that colour elimination is considerably better than the rule of thumb 10:1 ratio and that crystal yields are also better than assumed provided that the refinery is run correctly. That leads naturally to the acceptance of a higher colour fine liquor as can be seen in the balance.

In fact, Sugars® calculates the feed as a single stream and arrives at an average feed liquor colour of 650 with a product colour of 28 : a colour elimination factor of 23.2 : 1. That is rather simplistic because, as explained earlier, boiling is started with the low colour [340 ICUMSA] fine liquor and finished with the higher colour [1305 ICUMSA] high purity run-off from previous boilings.

Sugars International LLC began operations in November 1984 and development of the Sugars™ Computer Program began in January of 1985. The program was first used in 1985 to calculate the heat and material balance and to evaluate a sucrose separator for molasses desugarization at the Twin Falls beet sugar factory owned by the Amalgamated Sugar Company. The first copies of the program were licensed to Spreckels Sugar Company in May of 1986 and American Crystal Sugar Company in July of 1986. Other sugar companies began licensing it in 1987. The program was called PC-SUGARS at the time. The earliest versions of the program did not include integration of the evaporator balance into a model. With the release of version 2.20 on July 1, 1988, a completely integrated model of a sugar factory was possible for the first time, and the first models of complete beet sugar factories were built in July of 1988. The name of the program was simplified to Sugars when version 2.22 was released in November of 1988. In December of 1998, the new Sugars for Windows version of Sugars was introduced for the Microsoft Windows 95, 98 and NT 32 bit operating systems. The Windows version incorporated a full graphical interface for building models using Visio® software as the graphical diagramming engine. In 1999, Visio Corporation was purchased by Microsoft and subsequently Visio was integrated into the Microsoft Office product line.

The Advanced Monitoring System (AMS) was introduced in 2003 at the CITS meeting in Madrid, Spain as a joint development of Industrieprojekt GmbH and Sugars International LLC. This system is an add-on to Sugars for importing process data into the Sugars model to provide on demand mass, energy and color balances. It can substantially reduce the number of data points needed to evaluate a process. The AMS was first licensed to companies starting in 2004.

Many new features and enhancements have been added to Sugars to expand its versatility since its introduction in 1986. Today, Sugars can model beet, or cane sugar factories and refineries of almost any configuration. Sugar companies in more than thirty-five (35) countries have used it to predict how changes in the process and/or equipment will affect the performance of factories and refineries. The information from these predictions is used to make investment and process decisions. Sugars has modeled thousands of process variations covering both beet and cane and its results have been verified independently by actual factory data. It is the most widely used sugar process simulation program in the world.