Utilización de Aromas en Productos Lácteos Montse Ventura - Cristina Pereira

Ravetllat Aromatics, SL

Etiquetas:

Alimentos,

Food Technology,

Tecnología de los Alimentos,

Video

Geekye Capítulos 25 y 26

CN23TV

Cargando ...

Programas emitidos el 29 de noviembre y sábado 15 de diciembre de 2012 por CN23.

- Con Sebastián Di Nardo e Irina Sternik, entrevistamos a Pablo Toscano, Director Técnico de Ubisoft, creadores de Assassin's Creed. Además, hablamos con Cristian Aldana, cantante del Otro Yo, sobre música, redes sociales y tecnología.

- Se anunció Libre.ar! la operadora de telefonía e Internet del estado. Además, Made in Argentina: qué es la innovación social, de la mano de Ariel Gordon. Música maestra: Icon Cube.

- Con Marcelo Violni, hablamos de Tecnologías Sociales de la mano de Ariel Gordon. Con Sebastián Di Nardo, analizamos los 5 que no te podés perder del año que está acabando.

Fuente: CN23TV

Etiquetas:

Information Technology,

Tecnología de la Información,

Tecnologías,

Video

Proceso de Liofilización - Parte III Tecnologías para la Industria Alimentaria

Técnica Magalí Parzanese

- PREPARACIÓN

- CONGELACIÓN

- DESECACIÓN PRIMARIA

- DESECACIÓN SECUNDARIA

Antes de comenzar el proceso, es fundamental el acondicionamiento de la materia prima, ya que los productos liofilizados no pueden ser manipulados una vez completado el proceso. Lo que suele hacerse con alimentos como guisantes o arándanos es agujerear la piel con el objetivo de aumentar su permeabilidad. Los líquidos, por otro lado, se concentran previamente con el fin de bajar el contenido de agua, lo que acelera el proceso de liofilización. La segunda etapa se lleva a cabo en congeladores independientes (separados del equipo liofilizador) o en el mismo equipo. El objetivo es congelar el agua libre del producto. Para ello se trabaja a temperaturas entre -20 y -40°C. Para la optimización de este proceso es fundamental conocer y controlar:

La tercera etapa del proceso consiste en la desecación primaria del producto, por sublimación del solvente congelado (agua en la mayoría de los casos). Para este cambio de fase es necesario reducir la presión en el interior de la cámara, mediante una bomba de vacío, y aplicar calor al producto (calor de sublimación, alrededor de 550 Kcal/Kg en el caso del agua), sin subir la temperatura. Esto último se puede hacer mediante conducción, radiación o fuente de microondas. Los dos primeros se utilizan comercialmente combinándose su efecto al colocarse el producto en bandejas sobre placas calefactoras separadas una distancia bien definida. De esta manera se consigue calentar por conducción, en contacto directo desde el fondo y por radiación, desde la parte superior. Por otro lado la calefacción por medio de microondas presenta dificultad porque puede provocar fusión parcial del producto, debido a la potencial formación de puntos calientes en su interior; por lo cual actualmente no se aplica comercialmente. Los niveles de vacío y de calentamiento varían según el producto a tratar. Al inicio de esta tercera etapa, el hielo sublima desde la superficie del producto y a medida que avanza el proceso, el nivel de sublimación retrocede dentro de él, teniendo entonces que pasar el vapor por capas ya secas para salir del producto. Este vapor, se recoge en la superficie del condensador, el cual debe tener suficiente capacidad de enfriamiento para condensarlo todo, a una temperatura inferior a la del producto. Para mejorar el rendimiento de esta operación, es primordial efectuar controles sobre la velocidad de secado y sobre la velocidad de calentamiento de las bandejas. El primero se debe a que si el secado es demasiado rápido, el producto seco fluirá hacia el condensador junto con el producto seco. Produciéndose así una pérdida por arrastre de producto. El segundo de los controles, debe realizarse siempre ya que si se calienta el producto velozmente, el mismo fundirá y como consecuencia el producto perderá calidad.

Para evitarlo la temperatura de los productos debe estar siempre por debajo de la temperatura de las placas calefactoras mientras dure el cambio de fase. No obstante, al finalizar la desecación primaria, la temperatura del alimento subirá asintóticamente hacia la temperatura de las placas. Para tener una liofilización buena y rápida es necesario poder controlar exactamente esta temperatura y tener la posibilidad de regular la presión total y parcial del sistema. La cuarta y última etapa del proceso de liofilización, se trata de la desecación secundaria del producto por medio de desorción. Esta consiste en evaporar el agua no congelable, o agua ligada, que se encuentra en los alimentos; logrando que el porcentaje de humedad final sea menor al 2%.Como en este punto no existe agua libre, la temperatura de las bandejas puede subir sin riesgo de que se produzca fusión. Sin embargo, en esta etapa la presión disminuye al mínimo, por lo que se realiza a la máxima capacidad de vacío que pueda alcanzar el equipo. Es importante, finalmente, controlar el contenido final de humedad del producto, de manera que se corresponda con el exigido para garantizar su estabilidad.

- La temperatura en la que ocurre la máxima solidificación.

- La velocidad óptima de enfriamiento.

- La temperatura mínima de fusión incipiente.

La tercera etapa del proceso consiste en la desecación primaria del producto, por sublimación del solvente congelado (agua en la mayoría de los casos). Para este cambio de fase es necesario reducir la presión en el interior de la cámara, mediante una bomba de vacío, y aplicar calor al producto (calor de sublimación, alrededor de 550 Kcal/Kg en el caso del agua), sin subir la temperatura. Esto último se puede hacer mediante conducción, radiación o fuente de microondas. Los dos primeros se utilizan comercialmente combinándose su efecto al colocarse el producto en bandejas sobre placas calefactoras separadas una distancia bien definida. De esta manera se consigue calentar por conducción, en contacto directo desde el fondo y por radiación, desde la parte superior. Por otro lado la calefacción por medio de microondas presenta dificultad porque puede provocar fusión parcial del producto, debido a la potencial formación de puntos calientes en su interior; por lo cual actualmente no se aplica comercialmente. Los niveles de vacío y de calentamiento varían según el producto a tratar. Al inicio de esta tercera etapa, el hielo sublima desde la superficie del producto y a medida que avanza el proceso, el nivel de sublimación retrocede dentro de él, teniendo entonces que pasar el vapor por capas ya secas para salir del producto. Este vapor, se recoge en la superficie del condensador, el cual debe tener suficiente capacidad de enfriamiento para condensarlo todo, a una temperatura inferior a la del producto. Para mejorar el rendimiento de esta operación, es primordial efectuar controles sobre la velocidad de secado y sobre la velocidad de calentamiento de las bandejas. El primero se debe a que si el secado es demasiado rápido, el producto seco fluirá hacia el condensador junto con el producto seco. Produciéndose así una pérdida por arrastre de producto. El segundo de los controles, debe realizarse siempre ya que si se calienta el producto velozmente, el mismo fundirá y como consecuencia el producto perderá calidad.

Para evitarlo la temperatura de los productos debe estar siempre por debajo de la temperatura de las placas calefactoras mientras dure el cambio de fase. No obstante, al finalizar la desecación primaria, la temperatura del alimento subirá asintóticamente hacia la temperatura de las placas. Para tener una liofilización buena y rápida es necesario poder controlar exactamente esta temperatura y tener la posibilidad de regular la presión total y parcial del sistema. La cuarta y última etapa del proceso de liofilización, se trata de la desecación secundaria del producto por medio de desorción. Esta consiste en evaporar el agua no congelable, o agua ligada, que se encuentra en los alimentos; logrando que el porcentaje de humedad final sea menor al 2%.Como en este punto no existe agua libre, la temperatura de las bandejas puede subir sin riesgo de que se produzca fusión. Sin embargo, en esta etapa la presión disminuye al mínimo, por lo que se realiza a la máxima capacidad de vacío que pueda alcanzar el equipo. Es importante, finalmente, controlar el contenido final de humedad del producto, de manera que se corresponda con el exigido para garantizar su estabilidad.

Fuente:

Ver también: Parte I | Parte II

Etiquetas:

Alimentos,

Food Technology,

Tecnología de los Alimentos

Sector Sucroalcoholero Argentino Centro Azucarero Argentino

Etiquetas:

Alcohol,

Caña de Azúcar,

Sugarcane,

Tecnología Azucarera,

Video

Your Brain in the Cloud Ray Kurzweil

According to futurist Ray Kurzweil, we are going to create synthetic neocortexes in order to extend the power of our own neocortex.

Transcript

Sometimes people think that emotion and art are sort of sideshows to human intelligence and the real essence of intelligence is thinking logically. If that were true, computers are already smarter than we are because they're much better at logical thinking than we are. It's actually things like being funny, being sexy or expressing a loving sentiment; maybe in a poem or in a musical piece. That's the cutting edge of human intelligence.

It has to do with the hierarchy of the neocortex and at the low levels things might seem cold and mechanical because we're -- our neocortex can recognize very simple objects and make very simple decisions. At a high level, it's dealing with concepts like the beauty of a poem by Emily Dickinson or the ability to create a poem like that. And we can come back to creativity I believe it's an exercise in metaphors and the neocortex is a metaphor machine. That's what it's good at. That's why humans are creative, but we have this very large hierarchy where we have more and more abstract and complex patterns. You know, builds on patterns below it. And the difference between humans and say other primates is that we have more of the neocortex. We have this big forehead that we can fit in the frontal cortex and, therefore, have a higher number of hierarchies - of levels of the hierarchy. And that was an enabling factor that permitted the evolution of language and technology and art and science.

We are going to create synthetic neocortexes based on the same principles. I'm actually working on that. And we've had hierarchal systems like that. I helped pioneer a concept called Hierarchical Hidden Markup Models, which is similar to what happens in the brain but we only had a few levels. The brain has a very large number of levels and all the way from recognizing edges of objects up to "she's beautiful" or creating a beautiful painting or work of music, or scientific insight.

We will create artificial neocortex that have a comparable number or a greater number, and I think the principal application will actually be to extend our own neocortex. We have 300 million pattern recognizers in the neocortex by my estimate. That hierarchy we build ourselves each of these pattern recognizers capable of connecting itself to other neocortexes, to build its hierarchy. We build that hierarchy from the moment we're born or before that. We're constantly building it, but we run up against this limitation of 300 million. We'll be able to extend that and think in the cloud.

You know, if you do anything interesting with this, do a search or a language translation, or bring up a map or ask it a question. It doesn't take place in the box. It goes out to the cloud. We're going to put these just really gateways. This is a gateway to the cloud. We're going to put gateways to the cloud in our brains and have more than 300 million, just like the cloud can give you a thousand or a million computers for a tenth of a second. You need another billion pattern recognizers, you'll be able to access that in the cloud. That's where we're headed and we'll be more intelligent and able to actually think in a greater number of hierarchies. If you think that realize that the quantitative improvement from primates to humans with the big forehead to allow a larger neocortex was an enabling factor for language art and music and science. What kind of qualitative leap can we make with another quantitative increase? And that's I think where we're headed.

Directed / Produced by Jonathan Fowler & Elizabeth Rodd

Sometimes people think that emotion and art are sort of sideshows to human intelligence and the real essence of intelligence is thinking logically. If that were true, computers are already smarter than we are because they're much better at logical thinking than we are. It's actually things like being funny, being sexy or expressing a loving sentiment; maybe in a poem or in a musical piece. That's the cutting edge of human intelligence.

It has to do with the hierarchy of the neocortex and at the low levels things might seem cold and mechanical because we're -- our neocortex can recognize very simple objects and make very simple decisions. At a high level, it's dealing with concepts like the beauty of a poem by Emily Dickinson or the ability to create a poem like that. And we can come back to creativity I believe it's an exercise in metaphors and the neocortex is a metaphor machine. That's what it's good at. That's why humans are creative, but we have this very large hierarchy where we have more and more abstract and complex patterns. You know, builds on patterns below it. And the difference between humans and say other primates is that we have more of the neocortex. We have this big forehead that we can fit in the frontal cortex and, therefore, have a higher number of hierarchies - of levels of the hierarchy. And that was an enabling factor that permitted the evolution of language and technology and art and science.

We are going to create synthetic neocortexes based on the same principles. I'm actually working on that. And we've had hierarchal systems like that. I helped pioneer a concept called Hierarchical Hidden Markup Models, which is similar to what happens in the brain but we only had a few levels. The brain has a very large number of levels and all the way from recognizing edges of objects up to "she's beautiful" or creating a beautiful painting or work of music, or scientific insight.

We will create artificial neocortex that have a comparable number or a greater number, and I think the principal application will actually be to extend our own neocortex. We have 300 million pattern recognizers in the neocortex by my estimate. That hierarchy we build ourselves each of these pattern recognizers capable of connecting itself to other neocortexes, to build its hierarchy. We build that hierarchy from the moment we're born or before that. We're constantly building it, but we run up against this limitation of 300 million. We'll be able to extend that and think in the cloud.

You know, if you do anything interesting with this, do a search or a language translation, or bring up a map or ask it a question. It doesn't take place in the box. It goes out to the cloud. We're going to put these just really gateways. This is a gateway to the cloud. We're going to put gateways to the cloud in our brains and have more than 300 million, just like the cloud can give you a thousand or a million computers for a tenth of a second. You need another billion pattern recognizers, you'll be able to access that in the cloud. That's where we're headed and we'll be more intelligent and able to actually think in a greater number of hierarchies. If you think that realize that the quantitative improvement from primates to humans with the big forehead to allow a larger neocortex was an enabling factor for language art and music and science. What kind of qualitative leap can we make with another quantitative increase? And that's I think where we're headed.

Directed / Produced by Jonathan Fowler & Elizabeth Rodd

Fuente: bigthink

Pruebas de Aceptación Evaluación Sensorial

Elizabeth H. Alarcón

Principio de la prueba de aceptación

Permite medir además del grado de preferencia, la actitud del panelista o catador hacia un producto alimenticio, es decir se le pregunta al consumidor si estaría dispuesto a adquirirlo y por ende su gusto o disgusto frente al producto catado. Formato 21 y 22.

Permite medir además del grado de preferencia, la actitud del panelista o catador hacia un producto alimenticio, es decir se le pregunta al consumidor si estaría dispuesto a adquirirlo y por ende su gusto o disgusto frente al producto catado. Formato 21 y 22.

Casos en los que se aplica:

Para realizar el análisis de los datos, se puede determinar a través del anexo 1.2, cuál de las dos muestras es significativamente más preferido por los panelistas. Es necesario analizar las respuestas y comentarios realizados, para tomar decisiones. Para el formato 22, se analizan los datos asignando un valor a cada una de las categorías asi:

Me gustaría muchísimo comprarlo: 1

Me gustaría mucho comprarlo: 2

Me gustaría comprarlo: 3

Me es indiferente comprarlo: 4

Me disgustaría comprarlo: 5

Me disgustaría mucho comprarlo: 6

Me disgusta muchísimo comprarlo: 7

Luego se hace una tabla consolidada de los resultados de los panelistas, y se determina que tan significativas son las diferencias entre los dos tipos de sabores del helado en el caso del ejemplo, paro lo cual se determina a través del análisis de varianza ANOVA.

- Desarrollo de nuevos productos

- Cambiar tecnología

- Mejorara los productos

- Reducir costos

- Medir el tiempo de vida útil de los productos

- La aceptación

Para realizar el análisis de los datos, se puede determinar a través del anexo 1.2, cuál de las dos muestras es significativamente más preferido por los panelistas. Es necesario analizar las respuestas y comentarios realizados, para tomar decisiones. Para el formato 22, se analizan los datos asignando un valor a cada una de las categorías asi:

Me gustaría muchísimo comprarlo: 1

Me gustaría mucho comprarlo: 2

Me gustaría comprarlo: 3

Me es indiferente comprarlo: 4

Me disgustaría comprarlo: 5

Me disgustaría mucho comprarlo: 6

Me disgusta muchísimo comprarlo: 7

Luego se hace una tabla consolidada de los resultados de los panelistas, y se determina que tan significativas son las diferencias entre los dos tipos de sabores del helado en el caso del ejemplo, paro lo cual se determina a través del análisis de varianza ANOVA.

Ver también: 1 | 2 | 3 | 4 | 5 | 6 | 7 | 8 | 9 | 10 | 11 | 12 | 13 | 14 | 15 | 16 | 17

Balance de Población Reactores No Ideales

F. Cunill, M.Iborra, J.Tejero, C.Fité

Un tratamiento riguroso requiere conocer los perfiles de concentración, velocidad y temperatura. Dicho conocimiento permitiría describir con todo detalle el comportamiento del reactor. Mediante balances microscópicos y modelos de fenómenos de transporte se podría caracterizar determinadas regiones del reactor y con una posterior integración determinar el comportamiento del reactor. Sólo en determinados casos con una geometría particular y en régimen laminar es posible es posible este tipo de tratamiento. En general no es posible este enfoque por desconocer los perfiles y/o los coeficientes de transporte. En consecuencia, es preciso tratar el problema de otra forma, en concreto mediante métodos estadísticos.

Para obtener información de la macromezcla es suficiente conocer la permanencia de las moléculas dentro del reactor, es decir, la distribución de tiempos de residencia de la corriente de fluido. Dicha información estadística es manejada en los balances de población, introducidos en el campo de los reactores por Danckwerts (1953).

Los conceptos que intervienen en el balance de población aplicado a reactores son:

Es físicamente imposible conocer completamente y con detalle el modelo de flujo del fluido a través del recipiente. Sin embargo, con vistas al diseño, es suficiente en muchos casos conocer el tiempo de permanencia de los elementos de fluido en el recipiente. Aunque el flujo total no presenta variación alguna, no todos los elementos de fluido permanecen el mismo tiempo. La distribución de estos tiempos de residencia se describe mediante las funciones de distribución que se describen a continuación.

Función E(t) o de densidad de distribución de tiempos de residencia (de la corriente de salida)

La función distribución del tiempo de residencia del fluido (DTR) se define, de acuerdo con la teoría de probabilidades, como la frecuencia de distribución de edad de los elementos de fluido que abandonan el recipiente. Tiene las dimensiones de fracción de edad por unidad de tiempo. Así, la fracción de material de la corriente de salida que habiendo entrado a tiempo cero salen del recipiente a un tiempo comprendido entre t1 y t2, es igual a

La función distribución del tiempo de residencia del fluido (DTR) se define, de acuerdo con la teoría de probabilidades, como la frecuencia de distribución de edad de los elementos de fluido que abandonan el recipiente. Tiene las dimensiones de fracción de edad por unidad de tiempo. Así, la fracción de material de la corriente de salida que habiendo entrado a tiempo cero salen del recipiente a un tiempo comprendido entre t1 y t2, es igual a

Por tanto atendiendo a la definición de E(t) debe cumplirse

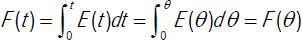

Función F(t) o distribución de tiempos de residencia acumulados

La función F(t) representa la fracción volumétrica de fluido que sale del recipiente y ha permanecido en el mismo un tiempo inferior a t. Si la densidad del sistema es constante la fracción volumétrica coincide con la másica.

Según esta definición, la probabilidad de que un elemento de fluido que entró en el reactor a tiempo 0 lo abandone antes de un tiempo t, es justamente F(t). Análogamente, la probabilidad de que lo abandone a un tiempo superior a t es (1-F(t)). De la propia definición también se desprende que

Tiempo medio de residencia, t (ρ=cte)

Se define como tiempo medio de residencia o permanencia de una corriente que circula con un caudal q a través de un recipiente de volumen V a la relación

siempre y cuando se cumplan las siguientes condiciones:

Las funciones de distribución de edad se pueden expresar de forma adimensional, introduciendo en las mismas el tiempo reducido o adimensional θ, definido por

Este cambio en la escala de tiempos tiene las siguientes consecuencias

Los conceptos que intervienen en el balance de población aplicado a reactores son:

- Elemento de fluido: toda porción caracterizable de fluido con propiedades fijas en el recipiente

- Edad: tiempo transcurrido desde que un elemento entra en el sistema hasta el instante considerado

- Tiempo de residencia: tiempo empleado por un elemento de fluido en recorrer el sistema desde la entrada a la salida

Es físicamente imposible conocer completamente y con detalle el modelo de flujo del fluido a través del recipiente. Sin embargo, con vistas al diseño, es suficiente en muchos casos conocer el tiempo de permanencia de los elementos de fluido en el recipiente. Aunque el flujo total no presenta variación alguna, no todos los elementos de fluido permanecen el mismo tiempo. La distribución de estos tiempos de residencia se describe mediante las funciones de distribución que se describen a continuación.

Función E(t) o de densidad de distribución de tiempos de residencia (de la corriente de salida)

Por tanto atendiendo a la definición de E(t) debe cumplirse

Función F(t) o distribución de tiempos de residencia acumulados

La función F(t) representa la fracción volumétrica de fluido que sale del recipiente y ha permanecido en el mismo un tiempo inferior a t. Si la densidad del sistema es constante la fracción volumétrica coincide con la másica.

Según esta definición, la probabilidad de que un elemento de fluido que entró en el reactor a tiempo 0 lo abandone antes de un tiempo t, es justamente F(t). Análogamente, la probabilidad de que lo abandone a un tiempo superior a t es (1-F(t)). De la propia definición también se desprende que

Tiempo medio de residencia, t (ρ=cte)

Se define como tiempo medio de residencia o permanencia de una corriente que circula con un caudal q a través de un recipiente de volumen V a la relación

siempre y cuando se cumplan las siguientes condiciones:

- la densidad de la corriente de fluido no varia a través del reactor

- el sistema es cerrado, es decir, en la entrada y salida del sistema el flujo es en pistón. Ello implica que no hay retromezcla

Las funciones de distribución de edad se pueden expresar de forma adimensional, introduciendo en las mismas el tiempo reducido o adimensional θ, definido por

Este cambio en la escala de tiempos tiene las siguientes consecuencias

si no hay ciertas desviaciones de flujo como zonas muertas o cortocircuitos

si no hay ciertas desviaciones de flujo como zonas muertas o cortocircuitos , la función F no varia ya que la fracción de fluido en la corriente de salida que ha permanecido en el recipiente un tiempo comprendido entre t y t+dt o entre θ y θ+dθ es la misma

, la función F no varia ya que la fracción de fluido en la corriente de salida que ha permanecido en el recipiente un tiempo comprendido entre t y t+dt o entre θ y θ+dθ es la misma

Ver también: 1 | 2 | 3 | 4 | 5 | 6 | 7 | 8 | 9 | 10 | 11 | 12 | 13 | 14 | 15 | 16 | 17 | 18 | 19 | 20 | 21 | 22 | 23 | 24 | 25 | 26 | 27 | 28 | 29 | 30

Geekye Capítulo 24

CN23TV

Cargando ...

Programa emitido el 1 de diciembre de 2012 por CN23.

- Mostramos una comparativa de discos rígidos NAS Western Digital My Book e Iomega EZ Media & Backup Center. En Paraná, Sociedades Digitales 2012, ntrevistamos a Neil Harbisson, el primer Cyborg reconocido por un gobierno

- En Geekye nos dimos el gusto de entrevistar a Horacio Fontova y hablar de tecnología, música y qué andará haciendo Steve Jobs en el más allá

Fuente: CN23TV

Etiquetas:

Information Technology,

Tecnología de la Información,

Tecnologías,

Video

El Código Genético Neandertal Homo Neanderthalensis

El hombre de Neandertal (Homo neanderthalensis) es una especie extinta del género Homo que habitó Europa y partes de Asia occidental desde hace 230.000 hasta 28.000 años atrás, durante el Pleistoceno medio y superior y culturalmente integrada en el Paleolítico medio. En un periodo de aproximadamente 5.000 años se cree convivió paralelamente en los mismos territorios europeos con el Hombre de Cro-Magnon, primeros hombres modernos en Europa.

Aislamiento del Leuconostoc Mesenteroides a partir de la elaboración de Chucrut

Dra. Blanca Estela Bravo

OBJETIVOS:

- Aislar la batería Leuconostoc Mesenteroides de un proceso fermentativo en este caso la elaboración de chucrut

- Identificar por medio de pruebas bioquímicas la bacteria aislada

- Preservar la cepa aislada mediante crio-preservación

El hombre ha aprovechado la acidificación de alimentos vegetales, que se inicia espontáneamente en ausencia de aire, para su transformación y conservación.

La aplicación más extendida y conocida de dichos procesos es la obtención de chucrut.

El chucrut es un producto estable y de sabor típico obtenido mediante un complejo fenómeno químico-microbiológico. Durante la fermentación la multiplicación de las bacterias lácticas, presentes naturalmente en las hojas del vegetal, da como resultado la disminución de la proliferación de microorganismos perjudiciales y el retraso o la inhibición de la alteración normal.

Además, la acumulación de ácidos orgánicos y otros metabolitos provocan cambios sensoriales y nutricionales. Generalmente, la fermentación se realiza en forma espontánea, pudiéndose detectar una sucesión de microorganismos específicos en cada una de las fases del proceso, como resultado de cambios en las condiciones ecológicas.

Los productos obtenidos a partir de fuentes reciclables, tales como los residuos agroindustriales, han merecido un interés creciente, debido a que permiten aminorar el impacto ambiental y los costos en el tratamiento y disposición de dichos residuos en las industrias. Un ejemplo de estos productos son los polisacáridos o biopolímeros.

La bacteria Leuconostoc Mesentoeroides degrada estos residuos y a partir de estos produce dextrano, un polisacárido de alto peso molecular, compuesto de unidades D-glucosa, unidos mediante enlaces glucosídicos α-(1-6); éste se lo utiliza en el área de los alimentos para dar viscosidad a ciertos productos.

Etiquetas:

Food Technology,

Microbiología,

Microbiology,

Papers,

Tecnología de los Alimentos

Desarrollo de Prebióticos y Probióticos Tecnologías para la Industria Alimentaria

Téc. Magalí Parzanese

En la industria alimentaria la innovación tecnológica favorece el desarrollo de productos de mayor calidad nutricional y organoléptica, e incluso permite extender su tiempo de vida útil. Para ser económicamente viables estos productos deben responder a las demandas de los consumidores, por lo que el desarrollo tecnológico se utiliza como medio para la satisfacción de las necesidades nutricionales de los diversos sectores de la sociedad. Al respecto en los últimos años aumentó la tendencia hacia una alimentación saludable y con ello el consumo de alimentos que no sólo satisfacen los requerimientos nutricionales diarios, si no que además presentan determinados beneficios para la salud o previenen el riesgo de padecer enfermedades. Los alimentos que poseen dichas características son conocidos en general como alimentos funcionales, aunque este término en la mayoría de los países, incluido Argentina, aún no tiene una definición legal. Dicho término tiene sus orígenes en Japón, durante la década del ochenta, donde se utilizó cómo expresión de marketing para denominar a aquellos alimentos fortificados con componentes especiales, que ofrecían ventajas fisiológicas. Años después en 1991 el Ministerio de Salud de ese país desarrolló una serie de normas para una categoría de alimentos relacionados con la salud, a los cuales denominó FOSHU (Food for Specified Health Uses). Las normas se dirigían a una serie de Health Claims (alegaciones saludables) que podían utilizarse para este conjunto. La atención e inquietud por los alimentos funcionales en Japón se expandió rápidamente hacia Europa y Estados Unidos. En estos lugares se tuvo en cuenta que los alimentos funcionales no sólo podrían disminuir los costos de salud publica, sino que también eran una excelente oportunidad para el crecimiento y desarrollo de la industria alimentaria.

Para comprender cuáles son las características presentes en aquellos alimentos que llevaron a la popularidad el término de “alimento funcional”, se puede mencionar la definición surgida durante la década del noventa del proyecto Functional Food Science in Europe (FuFoSE o Ciencia de los Alimentos Funcionales en Europa) elaborado por ILSI Europa (International Life Science Institute): “Un alimento puede considerarse funcional si se demuestra satisfactoriamente que ejerce un efecto beneficioso sobre una o más funciones selectivas del organismo, además de sus efectos nutritivos intrínsecos, de modo tal que resulte apropiado para mejorar el estado de salud y bienestar, reducir el riesgo de enfermedad o ambas cosas.” Asimismo estableció que deben seguir siendo alimentos y que sus efectos deben mostrarse en las cantidades normalmente consumidas en la dieta.

Como se mencionó en nuestro país aún no se incorporó al Código Alimentario Argentino (CAA) la definición del término “alimento funcional”, pero sí se cuenta con la denominación de alimentos adicionados con probióticos o prebióticos y por lo tanto se aceptó su uso como ingredientes alimenticios. Esto último indica que pueden utilizarse sin inconvenientes en el diseño, elaboración y comercialización de nuevos productos. Tales definiciones se hallan en los artículos 1389 y 1390 del capítulo XVII Alimentos de Régimen o Dietéticos del CAA.

En Argentina actualmente se presentan en el mercado una amplia variedad de alimentos prebióticos y probióticos los cuales se comercializan bajo distintas marcas comerciales, principalmente lácteos, panificados, alimentos infantiles y bebidas. A pesar de ello es necesario continuar investigando e innovando en el sector, ya que existen muchos compuestos que potencialmente podrían usarse en el desarrollo de nuevos productos, los cuales ampliarían la oferta de este tipo de alimentos en el mercado nacional.

Como se mencionó en nuestro país aún no se incorporó al Código Alimentario Argentino (CAA) la definición del término “alimento funcional”, pero sí se cuenta con la denominación de alimentos adicionados con probióticos o prebióticos y por lo tanto se aceptó su uso como ingredientes alimenticios. Esto último indica que pueden utilizarse sin inconvenientes en el diseño, elaboración y comercialización de nuevos productos. Tales definiciones se hallan en los artículos 1389 y 1390 del capítulo XVII Alimentos de Régimen o Dietéticos del CAA.

En Argentina actualmente se presentan en el mercado una amplia variedad de alimentos prebióticos y probióticos los cuales se comercializan bajo distintas marcas comerciales, principalmente lácteos, panificados, alimentos infantiles y bebidas. A pesar de ello es necesario continuar investigando e innovando en el sector, ya que existen muchos compuestos que potencialmente podrían usarse en el desarrollo de nuevos productos, los cuales ampliarían la oferta de este tipo de alimentos en el mercado nacional.

Fuente:

Aspen HYSYS V8 Activated Analysis

Introduction to activated energy and economic analysis in Aspen HYSYS V8.0. For more information, visit:

http://www.aspentech.com/products/activation/?origin=YT-Dec-12-aspen-hysys

Fuente:

Bombas Centrífugas Conceptos Básicos

Etiquetas:

Equipamiento Industrial,

Industrial Equipment,

Slides

Geekye Capítulo 23

CN23TV

Cargando ...

Programa emitido el sábado 10 de noviembre de 2012 por CN23.

Fuente: CN23TV

- * Sebastián Di Nardo nos cuenta las bondades del nuevo Need for Speed Most Wanted.

- * Mostramos cómo funciona la Philips Airfyer, una freidora sin aceite y hablamos con Marcelo Violini de la Moto Eléctrica Argentina, ganadora de Innovar. También hablamos Con Carlos Mesa y Pablo Pereira, desarrolladores.

Etiquetas:

Information Technology,

Tecnología de la Información,

Tecnologías,

Video

Método Pinch El análisis de pliegues

El diseño de una nueva planta química o de proceso, o la optimización de una planta existente, es un problema complejo, ya que siempre existen interacciones entre las unidades que forman el proceso, que hacen imposible abordar el diseño de cada una de estas unidades de forma individual. Esta metodología se puede resumir en los siguientes pasos:

- Se comienza el diseño en la capa más interna (el sistema de reacción), que representa la parte fundamental del proceso, ya que el funcionamiento de la capa interna afecta a todas las capas externas

- Se diseña esta sección de forma óptima de acuerdo a la información disponible (de momento incompleta)

- Se diseña el sistema de separación y recirculación, con lo que los balances de materia y energía quedan establecidos

- Se diseña el sistema de intercambio de calor y de recuperación energética de la planta, de forma que los consumos energéticos sean mínimos

- Se diseña el sistema de servicios generales (calefacción y refrigeración), que mejor cubran las necesidades energéticas de la planta

El análisis de pliegue (análisis Pinch)

En los últimos diez años el análisis de pliegue ha pasado de ser una herramienta dirigida a mejorar la eficiencia energética en el diseño de redes de recuperación de calor, a una metodología de optimación tanto para diseñar procesos nuevos como para modificar procesos existentes.

Actualmente incluye el diseño de:

- Redes de recuperación de calor

- Sistemas de separación

- Sistemas de remoción de desechos

- Sistemas de calor y potencia e) Sistemas de servicios auxiliares

- Complejos industriales

- Reducción del costo de capital

- Reducción del costo de la energía

- Reducción de emisiones contaminantes

- Optimación del uso del agua

- Mejoramiento de la operación y de la producción

Etiquetas:

Chemical Engineering Design,

Papers,

Pinch

La Dextranasa en la Producción de Azúcar Tecnología Azucarera

|

| Valores óptimos del pH y la temperatura de dextranasas sintetizadas por diferentes microorganismos. |

Fuente:

Efraín Rodríguez Jiménez

División Química-Física, Centro de Ingeniería Genética y Biotecnología, CIGB

Ave. 31 e/ 158 y 190, Cubanacán, Playa, AP 6162, CP 10 600, Ciudad de La Habana, Cuba

Fax: (537) 271 47 64; E-mail: efrain.rodriguez@cigb.edu.cu

División Química-Física, Centro de Ingeniería Genética y Biotecnología, CIGB

Ave. 31 e/ 158 y 190, Cubanacán, Playa, AP 6162, CP 10 600, Ciudad de La Habana, Cuba

Fax: (537) 271 47 64; E-mail: efrain.rodriguez@cigb.edu.cu

Etiquetas:

Caña de Azúcar,

Papers,

Sugarcane,

Tecnología Azucarera

Innovaciones y Aplicaciones con Extractos de Stevia Tereos - PureCircle Solutions

Etiquetas:

Alimentos,

Food Technology,

Tecnología de los Alimentos,

Video

Higiene en el Espacio Exterior Vida Aeroespacial

El astronauta Chris Hadfield muestra como se lavan las manos en forma rápida, dentro de una nave espacial.

Ozono en Alimentos Tecnologías para la Industria Alimentaria

Téc. Magali Parzanese

En toda industria donde se procesan alimentos es primordial el cuidado de la higiene y sanitización de sus instalaciones para asegurar la inocuidad de sus productos. Para ello, se utiliza tradicionalmente agua en conjunto con agentes desinfectantes como el cloro y sus derivados (hipoclorito de sodio, cloramina, dióxido de cloro, etc.). A su vez, la cloración ha sido el método predominante para el tratamiento de agua en plantas potabilizadoras en todo el mundo, debido a su bajo costo y a su efecto residual. No obstante, esta técnica presenta algunos inconvenientes importantes. Al respecto, en la década del 70 comenzaron a realizarse investigaciones sobre los diferentes subproductos de la cloración, y se descubrió que muchos de ellos, entre los que se destacan los trihalometanos (THM), especialmente el cloroformo, bromodiclorometano, dibromoclorometano y bromoformo, son potencialmente cancerígenos, representando un riesgo para la salud. Debido a estos resultados, desde hace tiempo se investiga el desarrollo de procesos alternativos de desinfección y sanitización que aseguren la inocuidad de los alimentos. Como consecuencia, surgieron métodos superiores a la cloración en cuanto a efectividad, como el tratamiento con radiación ultravioleta (desarrollado en la ficha Nº 2) y la ozonización.

En 1785 el científico holandés Von Marum sometió oxígeno puro y aire atmosférico a intensas descargas eléctricas. Como resultado obtuvo una reducción de los volúmenes de los gases, por lo que concluyó que durante las descargas ocurrían reacciones químicas, que daban como producto un gas de olor punzante característico. A partir de esto, describió al ozono científicamente, siendo el primero en hacerlo, aunque sin darle esta denominación. Años después, en 1840, Christian Schonbein continuó con los experimentos del holandés Von Marum, dando el nombre de ozono al gas investigado, palabra que proviene del griego “ozein” cuyo significado es “oler”.

Debido a su inestabilidad y elevado poder oxidante, el ozono actúa rápidamente rompiendo dobles enlaces y anillos aromáticos. Por ello, se lo utiliza como agente desinfectante en distintas aplicaciones, la más difundida es el tratamiento de aguas y en la desinfección de aire en distintos tipos de ambientes cerrados (posee acción microbicida y desodorizante). El O3 (ozono) es una alótropo del oxígeno termodinámicamente inestable, formado por tres moléculas de este elemento; su energía libre estándar de formación (ΔG°f) es positiva, por lo que el proceso de descomposición en moléculas de oxígeno diatómicas (O2) es espontáneo.

En medicina se lo utiliza para desinfectar quirófanos y otras salas y para el tratamiento de distintas patologías (ozonoterapia), ya que posee numerosos efectos benéficos para el metabolismo y la salud.

En la industria de los alimentos se usa como desinfectante de superficies que estén en contacto con alimentos, conservación, desinfección y desodorización, entre otras.

Debido a su inestabilidad y elevado poder oxidante, el ozono actúa rápidamente rompiendo dobles enlaces y anillos aromáticos. Por ello, se lo utiliza como agente desinfectante en distintas aplicaciones, la más difundida es el tratamiento de aguas y en la desinfección de aire en distintos tipos de ambientes cerrados (posee acción microbicida y desodorizante). El O3 (ozono) es una alótropo del oxígeno termodinámicamente inestable, formado por tres moléculas de este elemento; su energía libre estándar de formación (ΔG°f) es positiva, por lo que el proceso de descomposición en moléculas de oxígeno diatómicas (O2) es espontáneo.

En medicina se lo utiliza para desinfectar quirófanos y otras salas y para el tratamiento de distintas patologías (ozonoterapia), ya que posee numerosos efectos benéficos para el metabolismo y la salud.

En la industria de los alimentos se usa como desinfectante de superficies que estén en contacto con alimentos, conservación, desinfección y desodorización, entre otras.

Etiquetas:

Alimentos,

Food Technology,

Tecnología de los Alimentos

Geekye Capítulo 21

CN23TV

Cargando ...

Capítulo emitido el sábado 3 de noviembre de 2012 por CN23.

Fuente: CN23TV

- Leandro Viernes, músico, nos cuenta qué utiliza para armar "el bombo electrónico"

- Marcelo Violini, columnista de Geekye, nos presenta el proyecto Huayra, software libre en conectar igualdad. Con Vladimir Di Fiore, Cenital.

- Sebastián Di Nardo e Irina Sternik presentan un super versus de volantes y carreras. Level UP Race Force, Eurocase Montecarlo EUGA W-85 y Logitech G27.

Etiquetas:

Information Technology,

Tecnología de la Información,

Tecnologías,

Video

Pruebas de Satisfacción Evaluación Sensorial

Elizabeth H. Alarcón

Escala Hedónica Verbal

Principio de la prueba de escala hedónica verbal

Consiste en pedirle a los panelistas que den su informe sobre el grado de satisfacción que tienen de un producto, al presentársele una escala hedónica o de satisfacción, pueden ser verbales o gráficas, la escala verbal va desde me gusta muchísimo hasta me disgusta muchísimo, entonces las escalas deben ser impares con un punto intermedio de ni me gusta ni me disgusta y la escala gráfica consiste en la presentación de caritas o figuras faciales.

Principio de la prueba de escala hedónica verbal

Consiste en pedirle a los panelistas que den su informe sobre el grado de satisfacción que tienen de un producto, al presentársele una escala hedónica o de satisfacción, pueden ser verbales o gráficas, la escala verbal va desde me gusta muchísimo hasta me disgusta muchísimo, entonces las escalas deben ser impares con un punto intermedio de ni me gusta ni me disgusta y la escala gráfica consiste en la presentación de caritas o figuras faciales.

La escala más empleada para el desarrollo de esta prueba es la escala de Peryamm & Pilgrim, 1957. Formato 19.

Principio de la prueba de escala hedónica facial o gráfica

La escala gráfica, se utiliza cuando la escala tiene un gran tamaño presentándose dificultad para describir los puntos dentro de esta, también se emplea cuando el panel esta conformado por niños o por personas adultas con dificultades para leer o para concentrarse. Las escalas gráficas más empleadas son las hedónicas de caritas (Kramer y Twigg, 1972) con varias expresiones faciales. Los resultados obtenidos a través de esta prueba cuando se aplica a una población adulta no es muy confiable ya que les resulta ser un tanto infantiles. Formato 20.

Ventajas

Casos en los que se aplica:

La escala gráfica, se utiliza cuando la escala tiene un gran tamaño presentándose dificultad para describir los puntos dentro de esta, también se emplea cuando el panel esta conformado por niños o por personas adultas con dificultades para leer o para concentrarse. Las escalas gráficas más empleadas son las hedónicas de caritas (Kramer y Twigg, 1972) con varias expresiones faciales. Los resultados obtenidos a través de esta prueba cuando se aplica a una población adulta no es muy confiable ya que les resulta ser un tanto infantiles. Formato 20.

Ventajas

- La escala es clara para los consumidores

- Requiere de una mínima instrucción

- Resultado de respuestas con más información

- Las escalas hedónicas pueden ser por atributos

Casos en los que se aplica:

- Desarrollo de nuevos productos

- Medir el tiempo de vida útil de los productos

- Mejorar o igualar productos de la competencia

- Preferencia del consumidor

Ver también: 1 | 2 | 3 | 4 | 5 | 6 | 7 | 8 | 9 | 10 | 11 | 12 | 13 | 14 | 15 | 16

Suscribirse a:

Comentarios (Atom)